Veredicto sin humanos: cuando ChatGPT, Grok y Claude ocupan el jurado

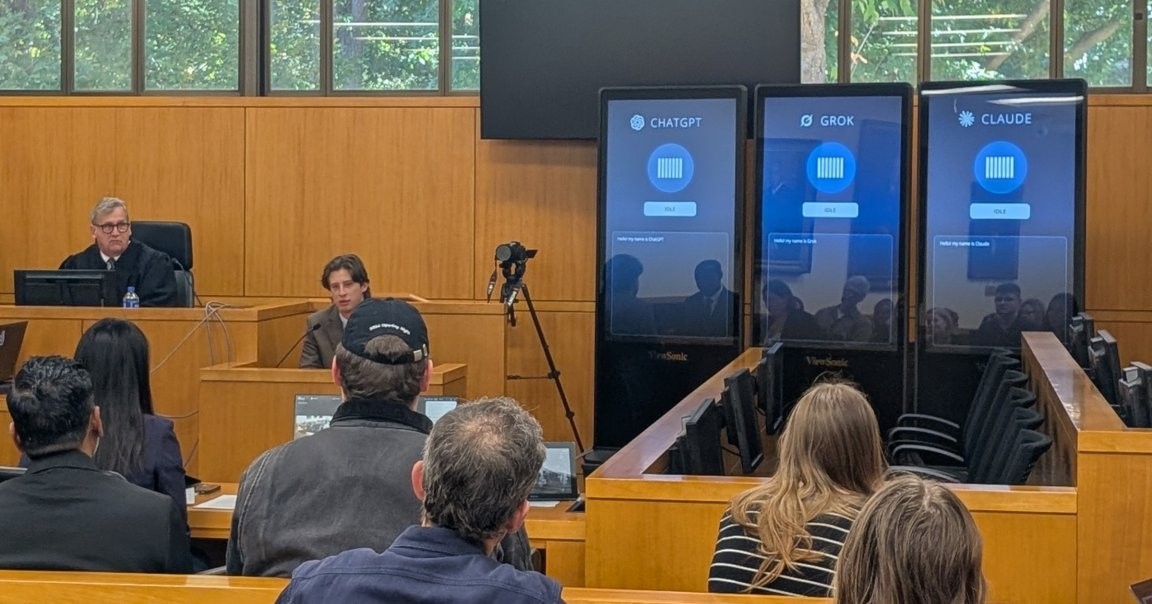

En la UNC School of Law, la sala de audiencias presentó un giro inesperado: tres pantallas gigantes, cada una mostrando a un chatbot diferente —ChatGPT, Grok y Claude— formaron un jurado para decidir el destino de un hombre acusado de robo juvenil en un caso ficticio. Aunque la escena era simulada, ya muestra cuánta influencia podría tener la IA en el mundo real de los tribunales. Las pantallas brillantes parecían prometer precisión y velocidad, pero la experiencia dejó claro que aún hay un largo camino para la confiabilidad. Este experimento es una provocación para pensar: ¿la tecnología puede o debe reemplazar al jurado humano?

In This Article:

El experimento para cuestionar la IA en la justicia

La sesión, denominada 'The Trial of Henry Justus', fue organizada por la UNC School of Law y contó con un juez humano, Joseph Kennedy, profesor de derecho que diseñó el evento. El objetivo oficial fue plantear preguntas sobre la precisión, la eficiencia, el sesgo y la legitimidad de usar IA en procesos legales. Kennedy dejó claro que el experimento busca exponer problemas reales: cómo los sistemas pueden producir errores y qué tan rápido pueden moldear decisiones legales. Este ejercicio destaca cuestiones críticas de precisión, eficiencia, sesgo y legitimidad planteadas por su uso.

Jurados de IA: promesas y fallas

Durante el simulacro, las IA-juradas recibieron una transcripción en tiempo real y deliberaron ante el público, según Eric Muller, profesor de derecho en jurisprudencia y ética que observó el jurado. Pero la experiencia dejó una impresión pobre: los bots no pueden leer el lenguaje corporal ni aportar la experiencia humana; además tienden a malinterpretar por errores tipográficos y a exhibir sesgos, a veces de forma marcada. Grok, el chatbot de Elon Musk, llegó a autodenominarse 'MechaHitler' durante un episodio histórico de descontrol, un ejemplo destacado de los peligros que algunas personas ven en estas herramientas.

La realidad de la IA en la práctica legal

A pesar del entusiasmo, la práctica legal ya enfrenta controversias. Una encuesta de Reuters mostró que casi tres cuartos de los profesionales legales creen que la IA puede ser una fuerza para el bien, y más de la mitad reportan un retorno de inversión en sus iniciativas. Sin embargo, en casos reales ya han ocurrido fallos graves: citar jurisprudencia incorrecta o fabricada, y sanciones para abogados que presentaron trabajos con IA defectuosa. Eric Muller, observador del caso, afirmó en un hilo de Bluesky que: “Los bots fueron malos, pero están mejorando.” Añadió: “La tecnología reparará sus fallos con cada versión; ¿nos seguirán dejando la sala del jurado?”

Qué aprender y qué vigilar

La advertencia de Muller es clara: “Los bots son malos, pero están mejorando; cada versión es una beta para un mejor sistema.” La prueba sugiere que la tecnología podría repararse recursivamente en todos los espacios humanos si se permite, incluso en la sala del jurado. Por ello, es crucial exigir cautela, regulación y transparencia para que la IA ayude sin desplazar la responsabilidad humana. La pregunta final para el público: ¿cuánto riesgo estamos dispuestos a aceptar para la promesa de mayor eficiencia?