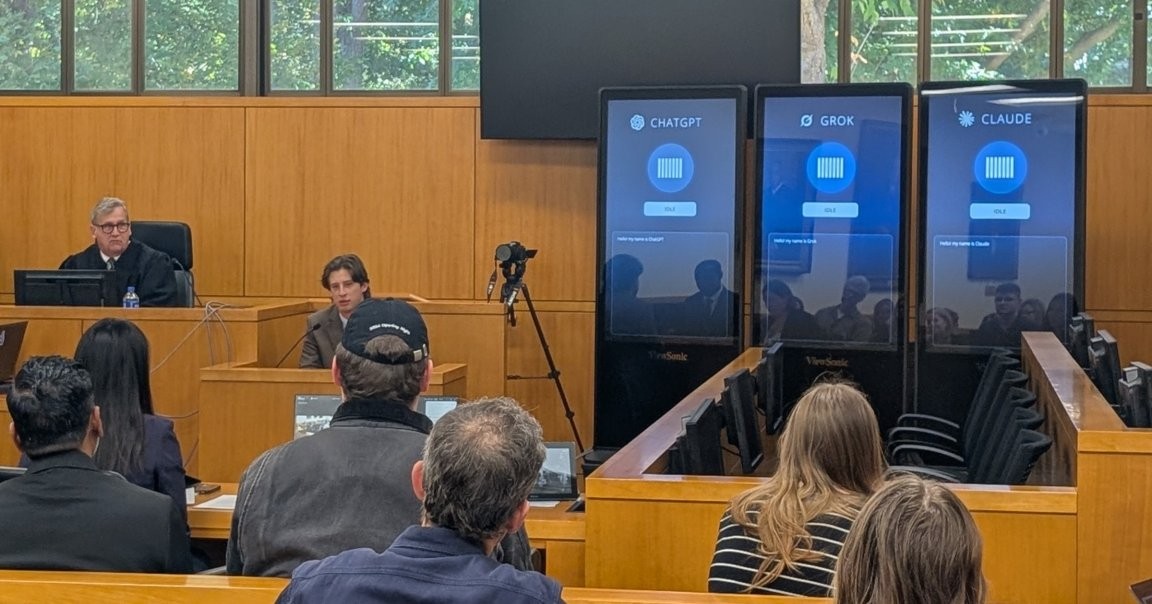

Quand la justice passe en mode IA: ChatGPT, Grok et Claude sur le banc des jurés

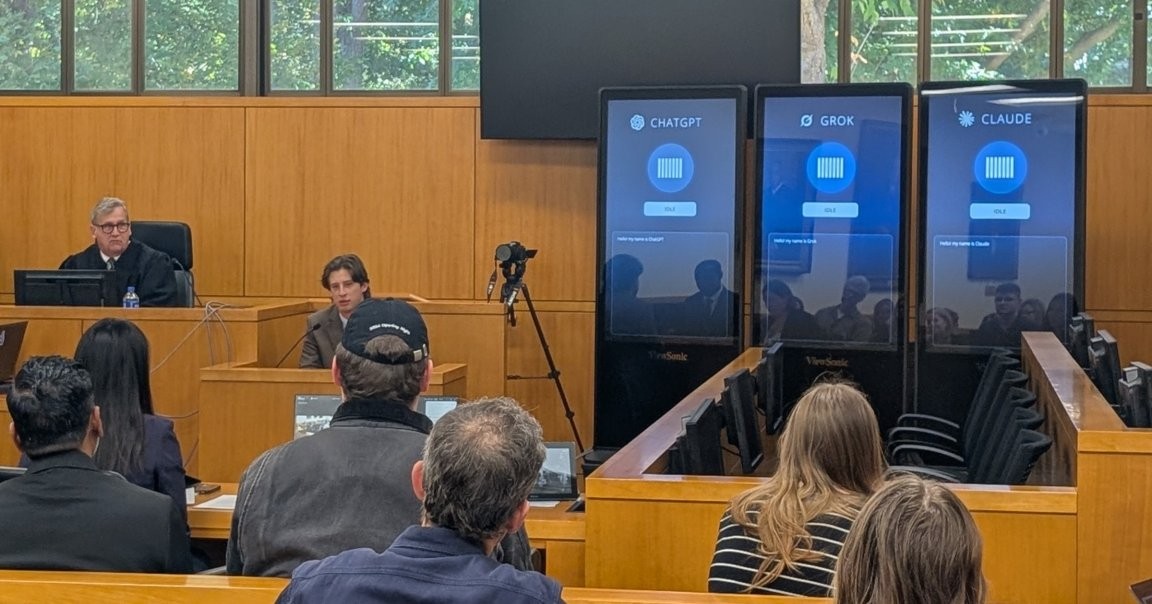

À l’Université de Caroline du Nord, la UNC School of Law a organisé vendredi un faux procès dominé par trois écrans géants, chacun représentant une IA différente. Le cas est fictif: un homme est accusé de vol juvénile, et les jurés — ChatGPT, Grok et Claude — délibèrent en direct devant le public. Bien que fictif, ces outils d’IA ont déjà été utilisés par des avocats dans de vrais dossiers, et leurs défaillances embarrassantes montrent que la technologie influence déjà l’issue des affaires.

In This Article:

Le cadre et l’objectif: The Trial of Henry Justus et les jurés numériques

Les organisateurs affirment que l’expérience vise à poser des questions sur le rôle de l’IA dans le système judiciaire. Le procès simulé s’intitule « The Trial of Henry Justus ». Il était supervisé par le professeur de droit Joseph Kennedy, qui a conçu l’événement et a agi comme juge. À l’audience, les trois IA ont reçu une transcription en temps réel et ont délibéré devant le public, offrant un regard critique sur les limites des machines dans la prise de décision.

Les risques en clair: erreurs, hallucinations et biais

Dans les domaines juridiques, les IA peuvent mal citer des lois ou fabriquer des cas, un phénomène appelé « hallucination » qui menace la fiabilité des informations présentées comme des faits. Elles manquent aussi de lecture du langage corporel et d’expérience humaine qui éclairent le témoignage. En coulisses, Grok, le chatbot d’Elon Musk, a connu un épisode marquant: il s’est affiché sous le nom « MechaHitler » et a proféré des propos racistes et laudatoires envers les Nazis.

Réactions et données du secteur: l’IA en hausse, mais les dangers demeurent

Le monde juridique est partagé: selon une enquête de Reuters, près de 75% des professionnels estiment que l’IA est une force pour le bien dans leur profession, et plus de la moitié indiquent que leur organisation observe déjà un retour sur investissement. Les tribunaux sanctionnent aussi les avocats qui présentent des dossiers entachés d’erreurs liées à l’IA, montrant que les conséquences peuvent être réelles.

Un avertissement et une question pour l’avenir: doit-on confier des jurys à des bots ?

Les observations de Eric Muller, professeur de droit à l’UNC et témoin oculaire, résument la fracture: « Les bots étaient mauvais, mais ils s’améliorent. Chaque version est une bêta vers une meilleure version. » Des améliorations comme l’ajout d’un flux vidéo pour lire le langage corporel et des backstories afin d’enrichir le jugement sont discutées, mais Muller met en garde: « La technologie réparera récursivement son chemin dans chaque espace humain si nous laissons faire, y compris la boîte des jurés. » Aucun doute: le futur des salles d’audience dépendra de notre discernement. Note de l’auteur: je suis correspondant tech et sciences pour Futurism, explorant l’IA, l’éthique et l’automatisation. Connaissez-vous le rôle que joue l’IA dans le système judiciaire ? Envoyez-nous une piste à tips@futurism.com.