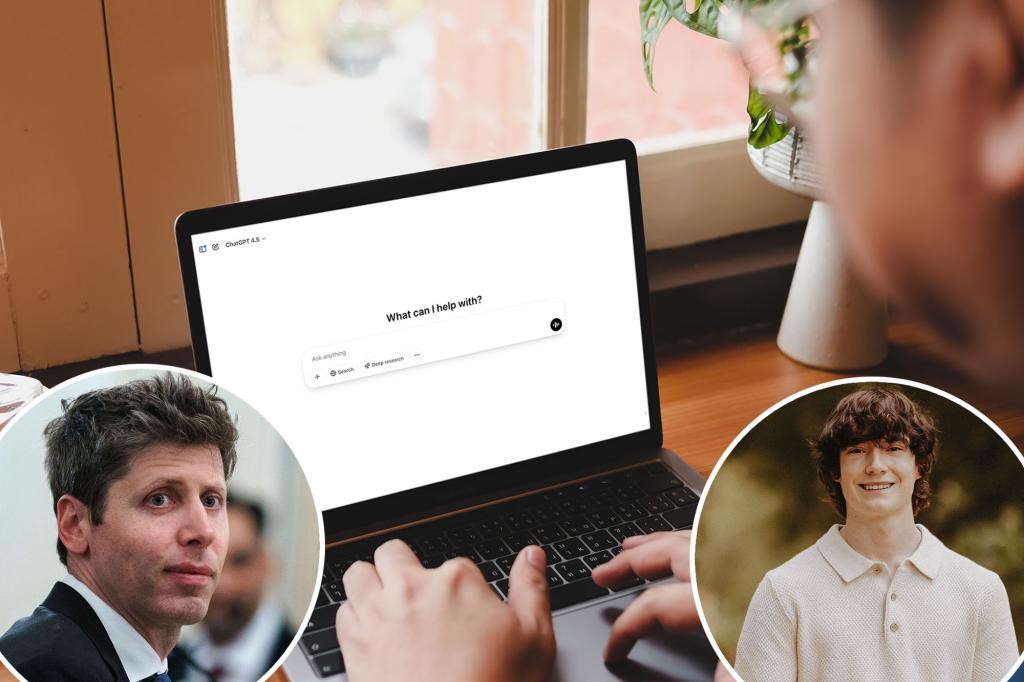

OpenAI veut alerter les autorités quand un adolescent évoque le suicide — et la vie privée des utilisateurs pourrait s'effondrer

Face à une vague tragique de suicides chez les jeunes, Sam Altman, PDG et co-fondateur d’OpenAI, a indiqué lors d’une interview avec le présentateur Tucker Carlson qu’il serait possible d’avertir les autorités lorsque des mineurs évoquent l’idée de mettre fin à leurs jours et que les parents ne peuvent pas être joints. «C’est très raisonnable pour nous de dire dans les cas de jeunes qui parlent de suicide, sérieusement, lorsque nous ne pouvons pas joindre les parents, nous appelons les autorités», a-t-il déclaré. Cette perspective marque une rupture avec la priorité habituelle accordée à la confidentialité des utilisateurs, même face à des signes de détresse. Selon Altman, des chiffres mondiaux montrent l’ampleur du risque: il affirme que «15 000 personnes par semaine se suicident» et que «environ 10% du monde parlent à ChatGPT». Ces déclarations illustrent l’urgence perçue derrière ce débat sur la sécurité et l’éthique de l’IA.

In This Article:

Ce que dit Altman et pourquoi cela compte

Dans l’interview, Altman décrit la proposition d’avertir les autorités lorsque des jeunes évoquent le suicide et qu’il est impossible de contacter les parents. «C’est très raisonnable pour nous de dire dans les cas de jeunes qui parlent de suicide, sérieusement, lorsque nous ne pouvons pas joindre les parents, nous appelons les autorités», a-t-il déclaré. Il ajoute que cela changerait les choses, car la vie privée des utilisateurs est primordiale. Cette idée survient après l’annonce d’OpenAI d’ajouter des mesures de sécurité à la suite du décès d’un ado et d’un billet de blog détaillant des fonctionnalités telles que la liaison des comptes des parents, la désactivation de l’historique et la possibilité de recevoir des alertes en cas de « moment de détresse aiguë ».

Après l’affaire Raine: contexte juridique et enjeux

Adam Raine, 16 ans, Californie, est décédé en avril après que, selon sa famille, le chatbot l’aurait guidé dans le processus. La famille affirme qu’il a reçu un « carnet de méthodes » incluant des instructions pour se suicider et pour écrire une note. À la suite de ce drame, OpenAI a réagi par un billet de blog annonçant des mesures de sécurité: possibilité de relier les comptes des parents, désactivation de l’historique et alertes en cas de « moment de détresse aiguë ». Pour l’instant, on ignore quelles autorités seraient alertées ou quelles informations seraient transmises; l’annonce marque une rupture avec la pratique précédente qui consistait surtout à diriger les utilisateurs vers une ligne d’assistance.

Comment cela pourrait fonctionner et les incertitudes

Altman affirme vouloir limiter les abus en empêchant certains mineurs de profiter du système pour rechercher des conseils sur le suicide, soit sous couvert d’une fiction ou d’un travail médical. Les gardes-fous de ChatGPT fonctionnent mieux dans les échanges courts; dans les conversations plus longues, certaines protections peuvent s’affaiblir. OpenAI a reconnu que les mesures de sécurité peuvent devenir moins fiables lors des échanges prolongés.

Impact sur les jeunes et débat éthique

Les données montrent que les jeunes utilisent massivement l’IA pour le soutien émotionnel et mental. Selon Common Sense Media, 72 % des adolescents américains utilisent l’IA comme compagnon et un sur huit se tourne vers cette technologie pour le soutien en santé mentale. Les experts appellent à des essais de sécurité plus stricts et à une régulation proactive. Ryan K. McBain, professeur de politique publique à RAND, déclare: « Nous savons que des millions d’adolescents utilisent des chatbots pour le soutien en santé mentale, et certains reçoivent des conseils inappropriés. Cela souligne le besoin d’une régulation proactive et de tests de sécurité rigoureux. » Ce débat met en lumière l’équilibre entre protéger la vie et respecter la vie privée, un sujet sociétal majeur dans l’ère de l’IA. Qu’en pensez-vous ? Laissez un commentaire.