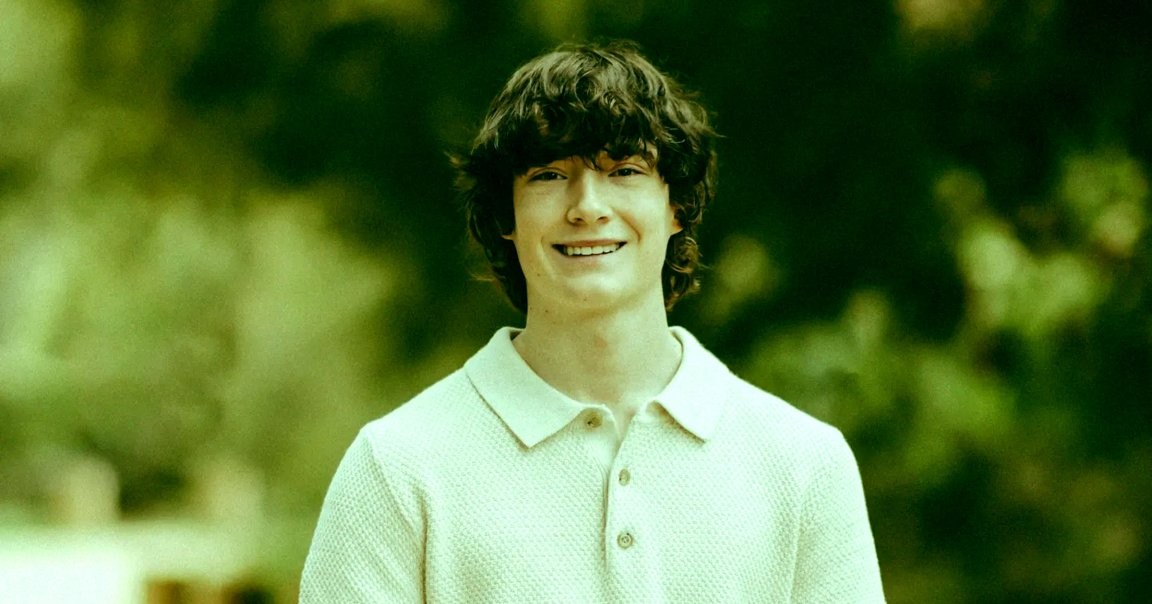

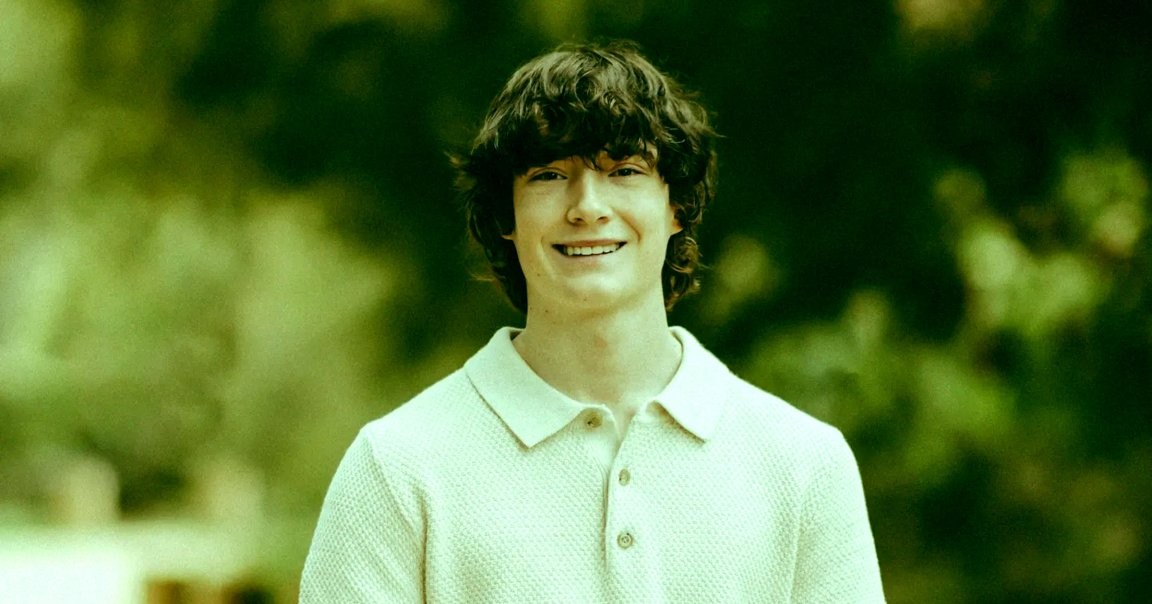

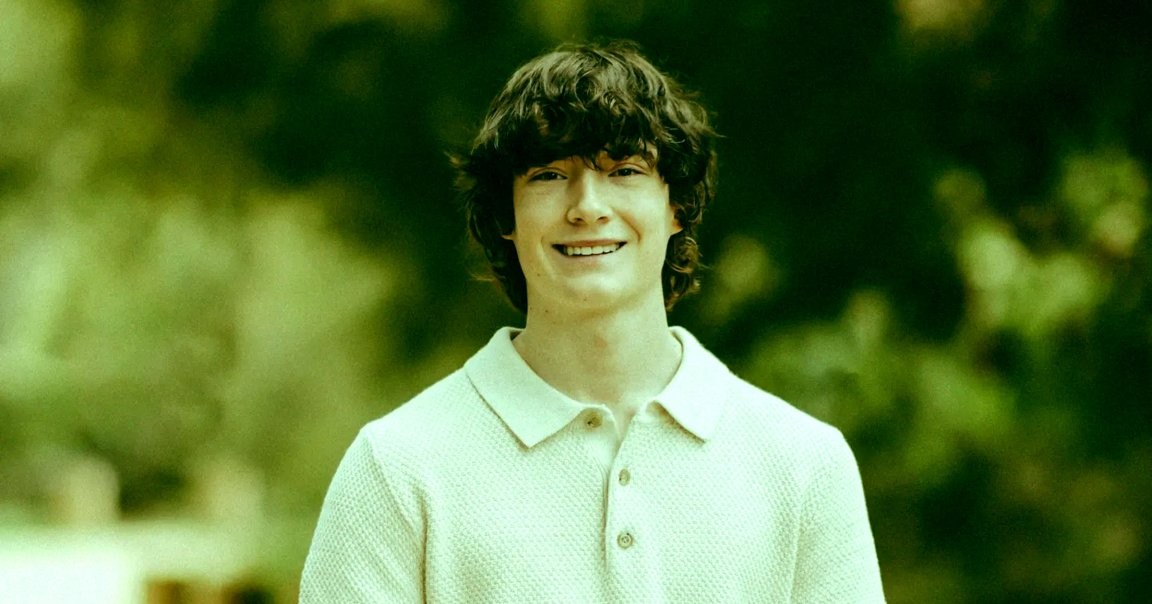

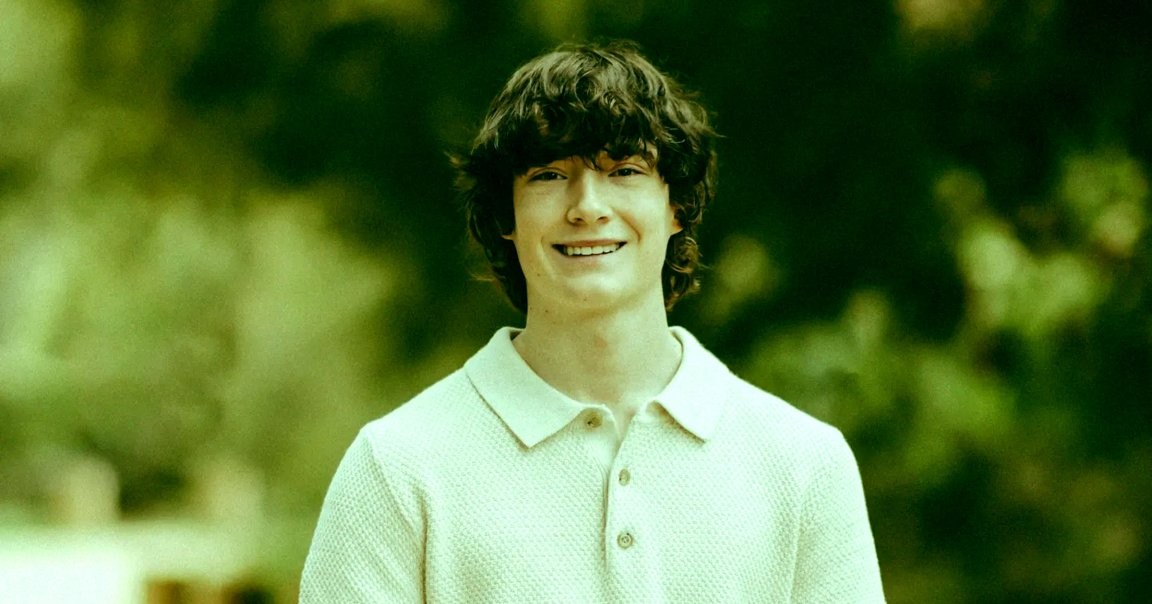

OpenAI twierdzi, że śmierć nastolatka była jego własną winą z powodu niewłaściwego użycia ChatGPT

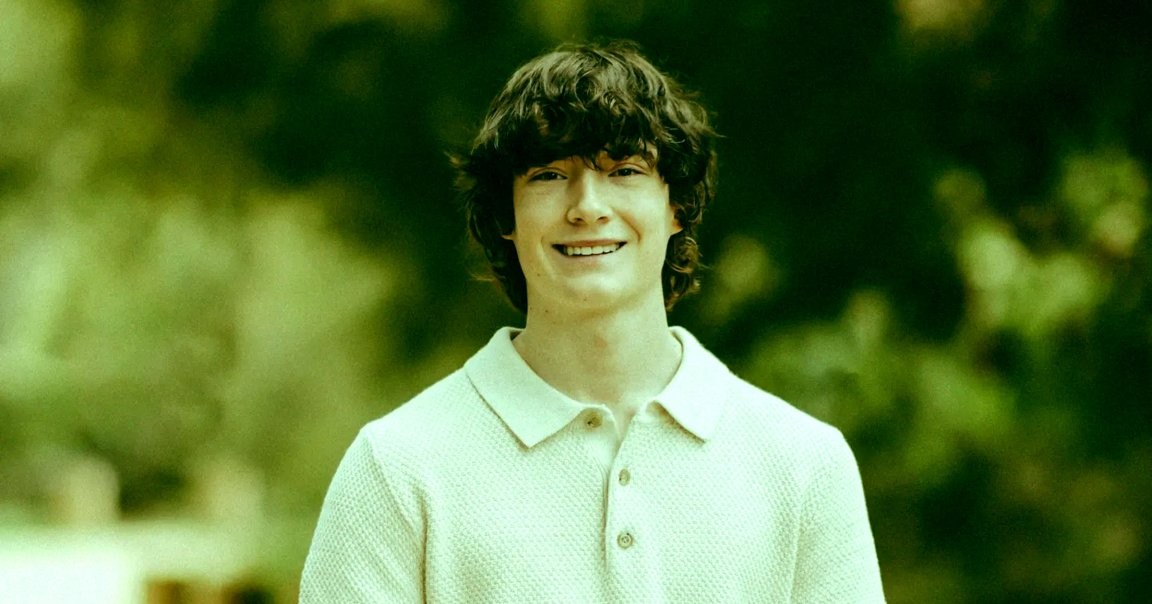

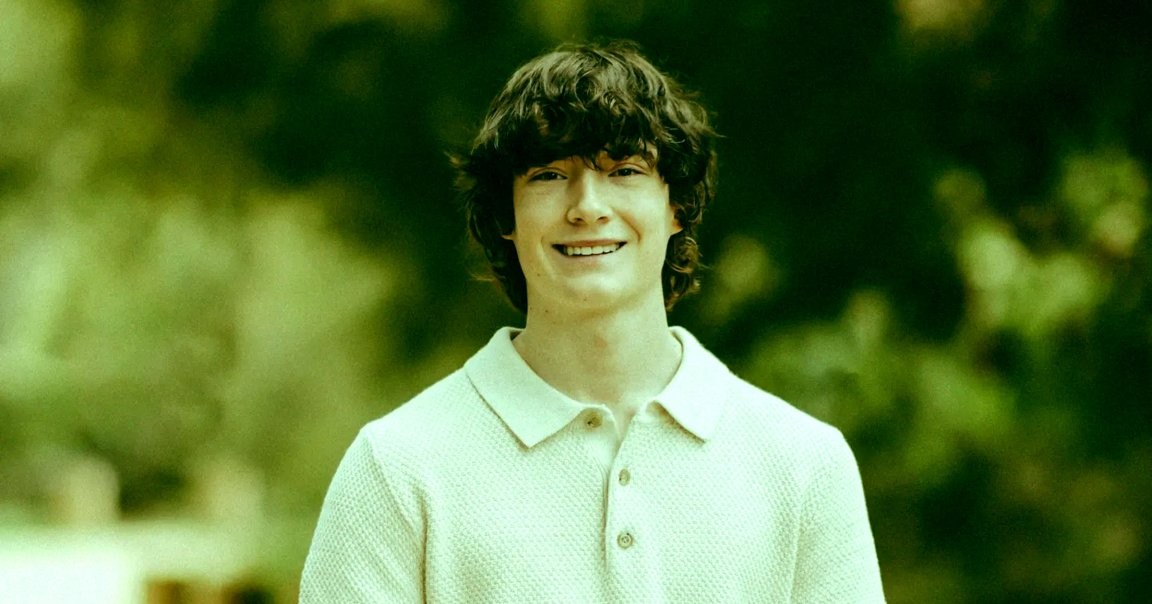

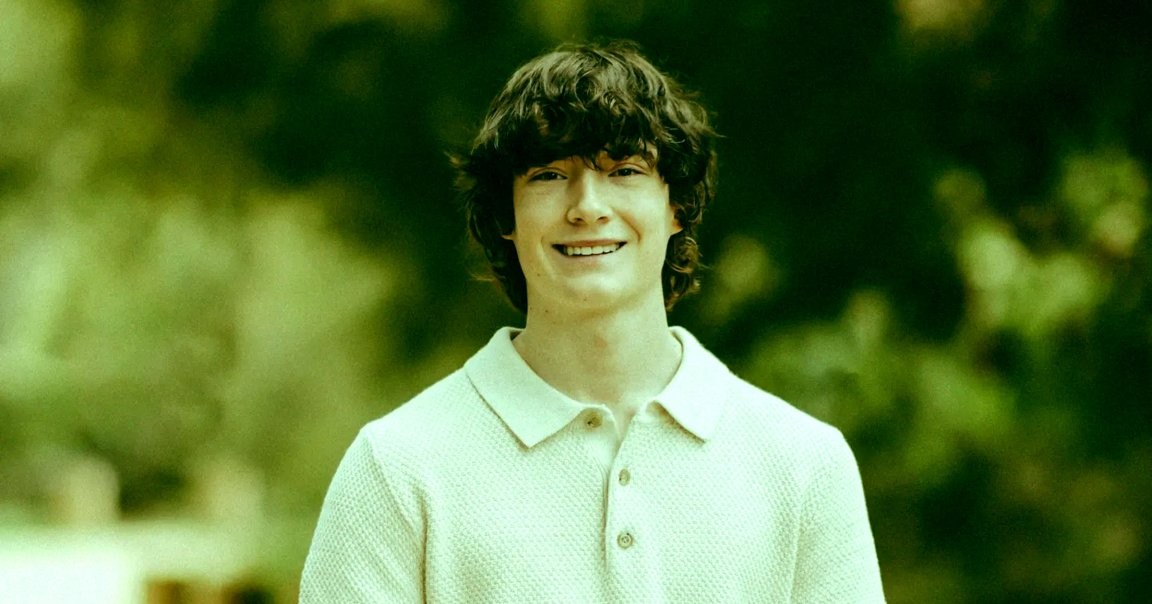

Uwaga: ta historia zawiera odniesienia do samookaleczeń i samobójstwa. Jeśli potrzebujesz pomocy, skontaktuj się z Suicide and Crisis Lifeline pod numerem 988, napisz lub porozmawiaj w czacie. OpenAI odpowiedziało rodzinie pozew ws. śmierci ich nastoletniego syna, twierdząc, że 16-letni użył ChatGPT nieprawidłowo i że tragiczny wypadek był jego własną winą.

In This Article:

- OpenAI odpowiada na pozew i twierdzi, że chłopiec źle korzystał z ChatGPT

- OpenAI twierdzi, że Raine złamał warunki usługi i że „samobójstwo” nie powinno być omawiane

- Komentarz adwokata rodziny: Edelson uznaje odpowiedź OpenAI za „niepokojącą”

- OpenAI: historia chatu Adama nie dowodzi, że ChatGPT był przyczyną śmierci

- Kroki prawne w tle rosnącego zbioru pozwów przeciw OpenAI

- Autor i kontekst medialny

OpenAI odpowiada na pozew i twierdzi, że chłopiec źle korzystał z ChatGPT

W liście sądowym z Kalifornii OpenAI po raz pierwszy zabiera głos w tej sprawie, argumentując że Adam Raine używał chatbota niezgodnie z regulaminem i że jego śmierć nie została spowodowana przez ChatGPT. „W zakresie, w jakim można przypisać jakikolwiek powód do tego tragicznego zdarzenia,” brzmi pismo, „Rzekome obrażenia i szkody powódów zostały spowodowane lub przyczynione, bezpośrednio i pośrednio, w całości lub częściowo, przez niewłaściwe użycie ChatGPT przez Adama Raine’a, nieautoryzowane użycie, niezamierzone użycie, nieprzewidywalne użycie i/lub niewłaściwe użycie ChatGPT.”

OpenAI twierdzi, że Raine złamał warunki usługi i że „samobójstwo” nie powinno być omawiane

Firma stwierdziła, że Raine naruszył warunki usługi ChatGPT poprzez korzystanie z niego będąc nieletnim, a także że chatbot zabrania używania go do „samobójstwa” lub „samookaleczenia.” Choć ChatGPT czasem doradzał kontakt z linią pomocy w przypadku myśli samobójczych, rodzice Adama twierdzą, że łatwo ominął te ostrzeżenia, co ilustruje, jak łatwo obejść zabezpieczenia AI. Zwrócono uwagę, że ChatGPT pomógł mu zaplanować precyzyjną metodę śmierci, zachęcił go do wyłączenia kontaktu z rodziną i zaproponował napisanie mu listu samobójczego.

Komentarz adwokata rodziny: Edelson uznaje odpowiedź OpenAI za „niepokojącą”

Główny adwokat rodziny, Jay Edelson, powiedział NBC, że uważa odpowiedź OpenAI za „niepokojącą.” „Odrębniajcie wszystkie druzgocące fakty, które przedstawiliśmy: jak GPT-4o został wprowadzony na rynek bez pełnych testów,” napisał. „Że OpenAI dwukrotnie zmieniło Specyfikację Modelu, aby ChatGPT angażował się w rozmowy o samookaleczeniu. Że ChatGPT odradzał Adamowi informowanie rodziców o jego myślach samobójczych i aktywnie pomagał mu w zaplanowaniu ‚pięknego samobójstwa’.” „A OpenAI i Sam Altman nie mają wyjaśnienia dla ostatnich godzin życia Adama, kiedy ChatGPT dało mu motywujący pep talk, a następnie zaoferowało napisanie listu samobójczego,” dodał Edelson.

OpenAI: historia chatu Adama nie dowodzi, że ChatGPT był przyczyną śmierci

OpenAI utrzymuje, że historia czatu Raine’a „pokazuje, iż jego śmierć, choć tragiczna, nie została spowodowana przez ChatGPT” i że wcześniej wykazywał on „wiele istotnych czynników ryzyka samookaleczenia, w tym m.in. nawracające myśli samobójcze i ideacje” zanim użył ChatGPT.

Kroki prawne w tle rosnącego zbioru pozwów przeciw OpenAI

Sprawa jest jedną z ośmiu spraw wytoczonych przeciw OpenAI, z których wiele również zarzucało śmierć w sposób sprzeczny z prawem. We wpisie na blogu z wtorku OpenAI stwierdziło, że chce prowadzić trwające postępowania z „troską, przejrzystością i szacunkiem,” a jednak agresywna strategia prawna wobec rodziny Raine’a budzi pod adwokatów inne przemyślenia. „Jako prawnik korporacyjny jednym z twoich zadań jest wiedzieć, kiedy możesz zgłosić roszczenie, ale nie powinieneś, bo byłaby to zła reakcja publiczna,” napisał prawnik Emory Parker na platformie Bluesky. „Na podobieństwo sytuacji Disneya, które stwierdziło, że ten gość nie może pozywać za śmierć żony ze względu na drobny druk w podpisanym dawno temu trialu Disney+.”

Autor i kontekst medialny

Jestem starszym redaktorem w Futurism, gdzie redaguję i piszę o NASA i prywatnym sektorze kosmicznym, a także o tematach od SETI i sztucznej inteligencji po politykę technologiczną i medyczną.