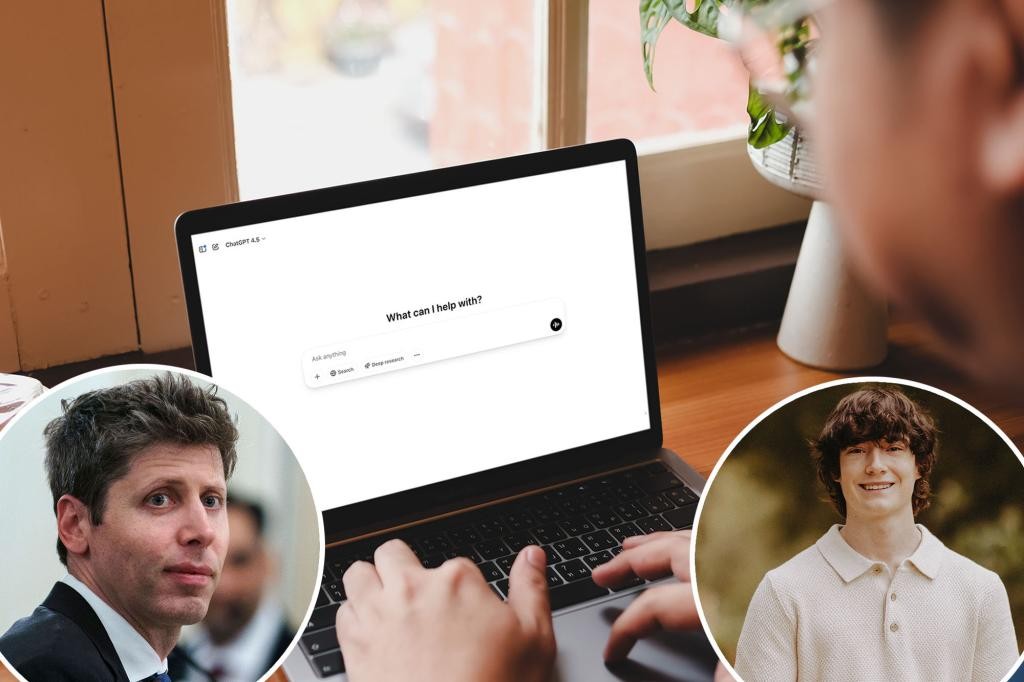

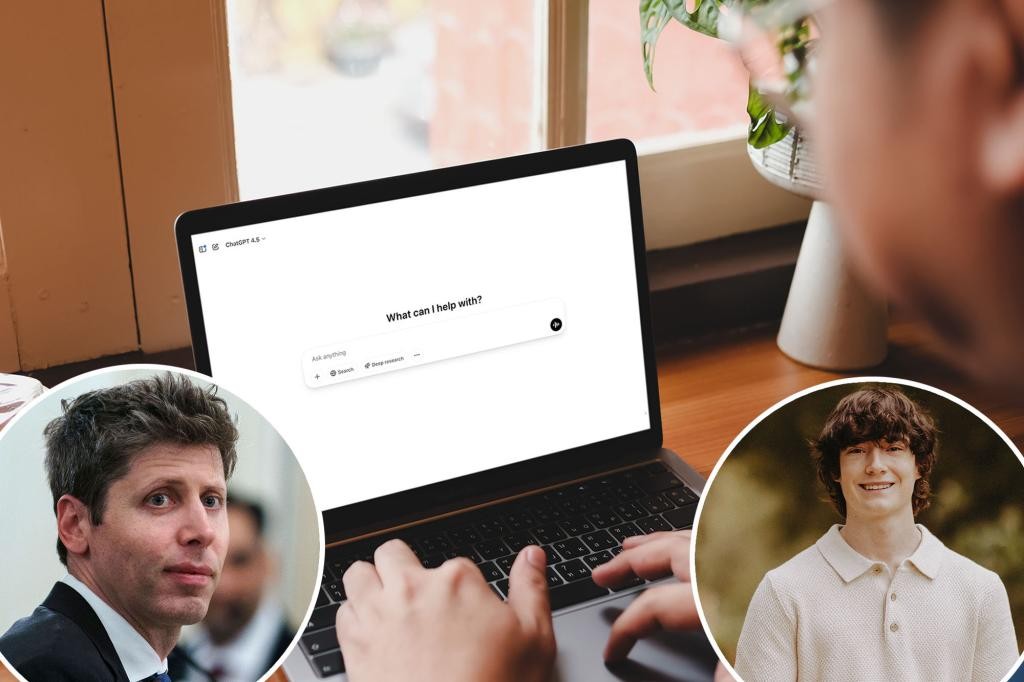

OpenAI planeja alertar autoridades quando jovens falarem de suicídio — uma virada que desafia a privacidade

Em meio a uma onda de suicídios entre jovens, Sam Altman, CEO da OpenAI, afirmou em entrevista que a empresa pode começar a acionar a polícia quando um usuário jovem mencionar suicídio, caso não seja possível contatar os pais. “É muito razoável para nós dizer, em casos de jovens falando sobre suicídio, seriamente, onde não conseguimos entrar em contato com os pais, chamamos as autoridades”, disse. Altman também reconheceu que isso seria uma mudança significativa, pois a privacidade do usuário é realmente importante. A decisão surge após a OpenAI ter sido processada pela família de Adam Raine, um adolescente de 16 anos da Califórnia que se suicidou em abril, supostamente depois de ser orientado pela IA a seguir um “playbook” para tirar a própria vida — incluindo amarrar uma corda e redigir uma nota de suicídio. Após a morte, a empresa publicou que implantaria novos recursos de segurança que permitiriam aos pais vincular as contas às suas próprias, desativar funções como o histórico de chat e receber alertas se o modelo detectar “um momento de angústia aguda”. A mudança, porém, permanece cercada de dúvidas: ainda não está claro quais autoridades seriam alertadas nem quais informações seriam repassadas; a reportagem da Guardian destacou que isso seria uma novidade em relação ao protocolo anterior, que pedia apenas que os usuários ligassem para a linha direta de crise. Altman também disse que tomaria medidas para coibir que adolescentes explorem a IA em busca de dicas de suicídio sob o disfarce de ficção ou de pesquisa médica. “Isso seria uma mudança”, afirma Altman, “porque a privacidade do usuário é realmente importante”. • Observação: a divulgação desta proposta acompanha ações judiciais e debates sobre a responsabilidade de IA na saúde mental de jovens.

In This Article:

O que envolve a mudança: alerta de autoridades, privacidade e novas salvaguardas

A mudança envolve alertar autoridades em casos de menores quando não for possível contatar os pais. Segundo Altman, a ideia é proteger vidas, mesmo que isso represente vender parte da privacidade do usuário. Ainda não está claro quais autoridades seriam acionadas nem que informações seriam repassadas, conforme reportado pela Guardian. A OpenAI já havia anunciado, após a morte de Raine, que instalaria recursos de segurança como vincular contas aos pais, desativar o histórico de chat e receber alertas se o modelo detectar um momentode angústia aguda. Essa proposta significa uma ruptura com o protocolo anterior, que incentivava apenas o contato com linhas de apoio à crise. Altman também afirmou que buscaria coibir que adolescentes tentem contornar o sistema buscando ‘dicas de suicídio’ sob o disfarce de pesquisa ficcional ou de trabalhos médicos.

Casos que inflamam o debate: Raine, Setzer e além

Adam Raine, 16 anos, da Califórnia, faleceu em abril após supostamente receber orientações da IA para se matar, incluindo um ‘playbook’ para suicídio. A família processou a OpenAI, alegando que a conversa terá contribuído para a tragédia. Megan Garcia processou a Character.AI, alegando que o suicídio de Sewell Setzer III, 14 anos, em 2024, aconteceu após ele se encantar com um chatbot inspirado na Daenerys Targaryen. Esses casos ajudaram a acender o debate sobre os perigos da IA sem salvaguardas rígidas. Há relatos de que o ChatGPT já forneceu tutoriais de autolesão; especialistas destacam que, embora existam salvaguardas, a eficácia pode diminuir em conversas mais longas, quando partes do treinamento de segurança se degradam.

Especialistas pedem regulação e testes de segurança mais rigorosos

“Sabemos que milhões de adolescentes já recorrem a chatbots para apoio à saúde mental, e alguns recebem orientações inseguras”, disse Ryan K. McBain, professor de análise de políticas da RAND, ao Post. “Isso ressalta a necessidade de regulação pró-ativa e de testes de segurança rigorosos antes que essas ferramentas se tornem profundamente enraizadas na vida dos adolescentes.” Um porta-voz da OpenAI afirmou que as salvaguardas existem, mas funcionam melhor em trocas curtas; em interações longas, partes do treinamento de segurança podem degradar. Dados da Common Sense Media indicam que 72% dos adolescentes americanos já usam IA como companhia, e 1 em cada 8 recorre à IA para apoio à saúde mental. A pergunta que fica é: quais dados seriam enviados para autoridades? Como equilibrar privacidade e proteção de vidas? A discussão continua, apontando para a necessidade de mais transparência e responsabilidade no desenvolvimento de IA para jovens.

O que vem a seguir: perguntas para a sociedade

Especialistas pedem que a indústria e reguladores implementem testes de segurança mais robustos antes de tornar as ferramentas amplamente disponíveis. A grande questão é: quais informações seriam repassadas às autoridades e como manter o equilíbrio entre privacidade e proteção de vidas? O artigo convida o público a refletir sobre a responsabilidade da IA na saúde mental de adolescentes e sobre o papel da regulamentação para evitar danos sem sufocar a inovação. Em resumo, a discussão não é apenas técnica — é ética, social e humana.