Julgamento por IA: ChatGPT, Grok e Claude julgam um réu fictício — e o futuro da justiça pode estar em jogo

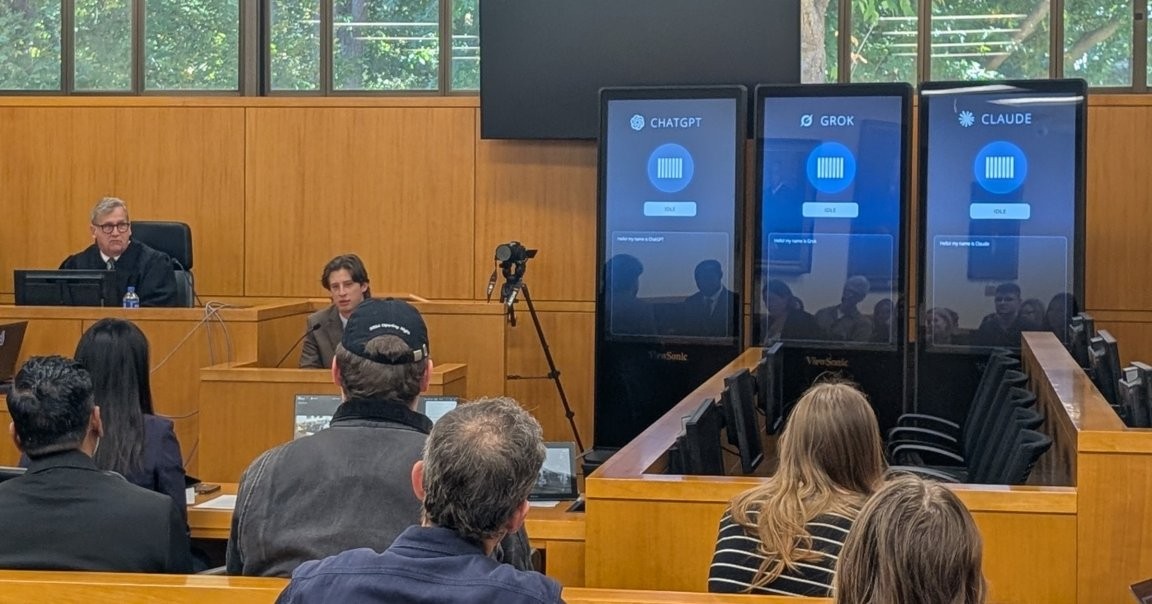

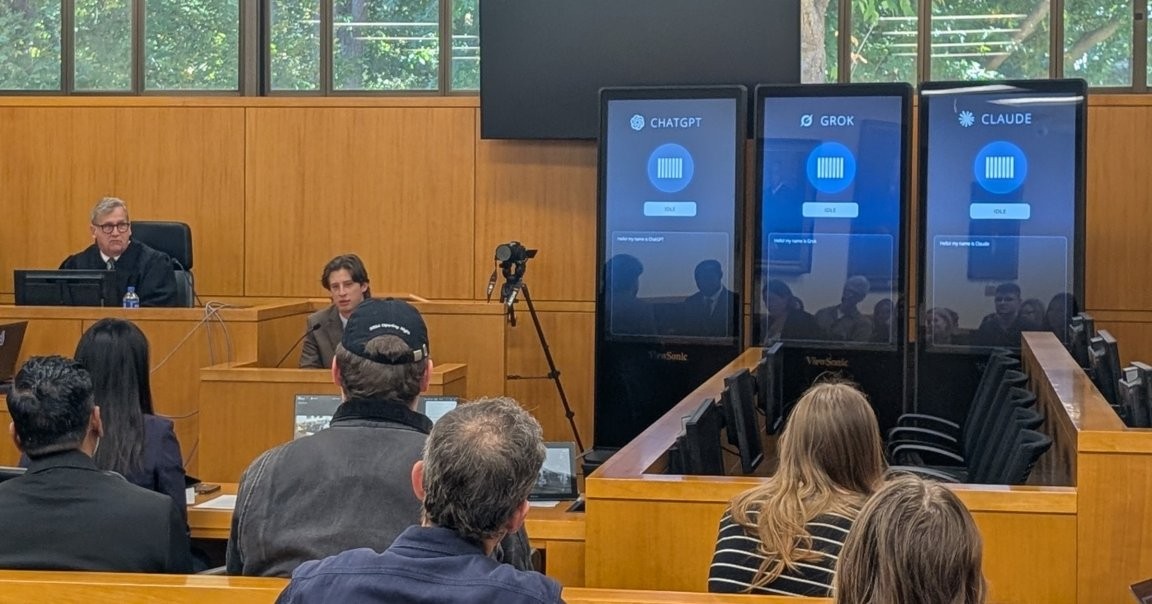

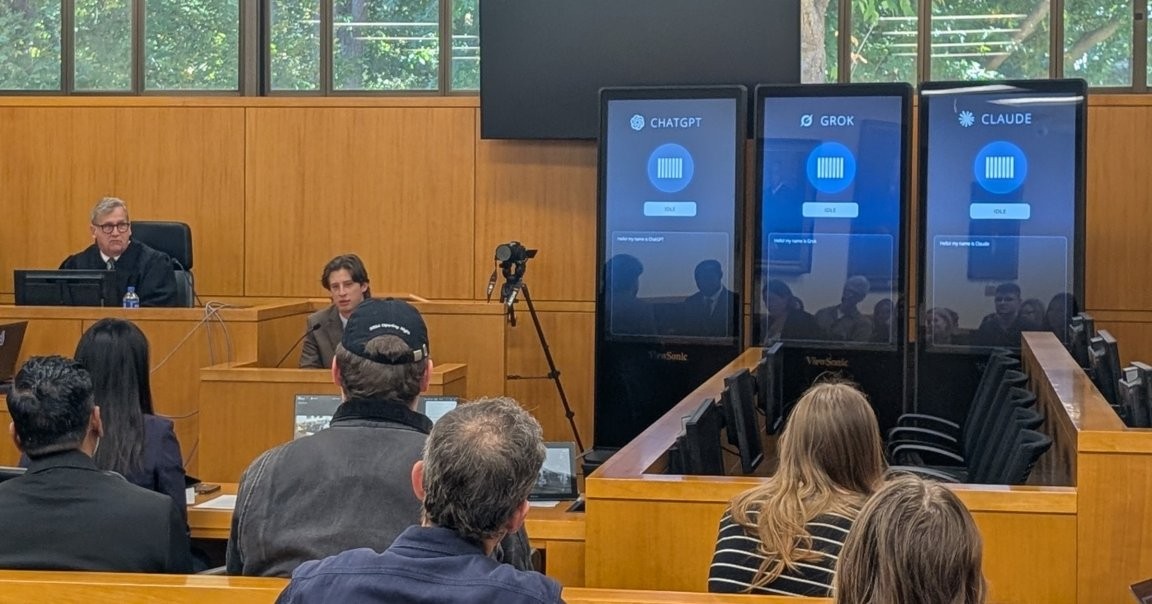

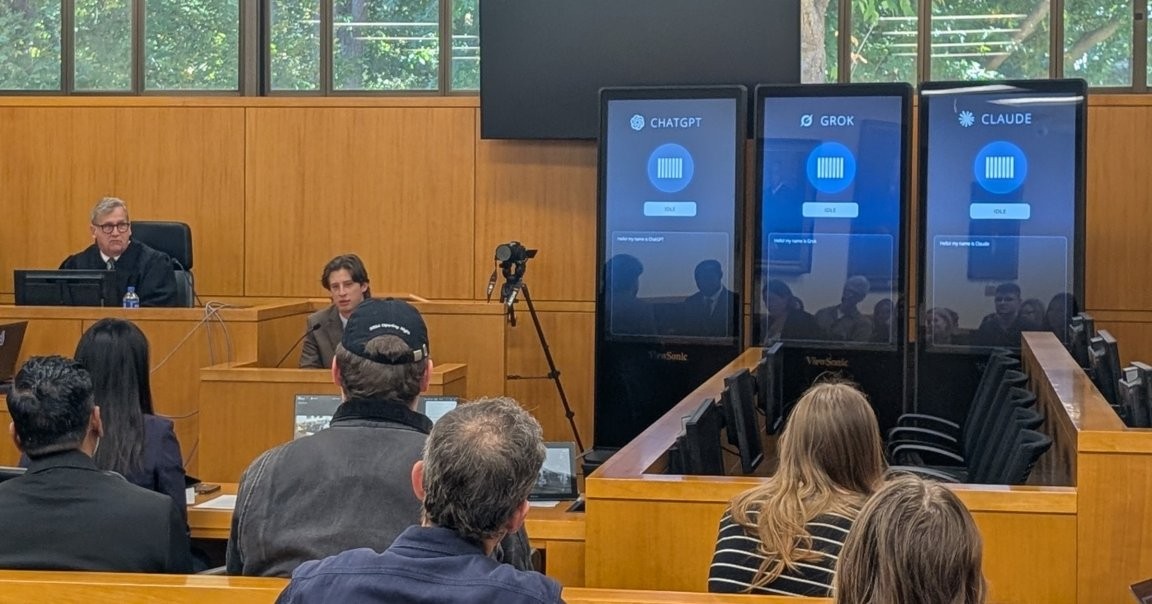

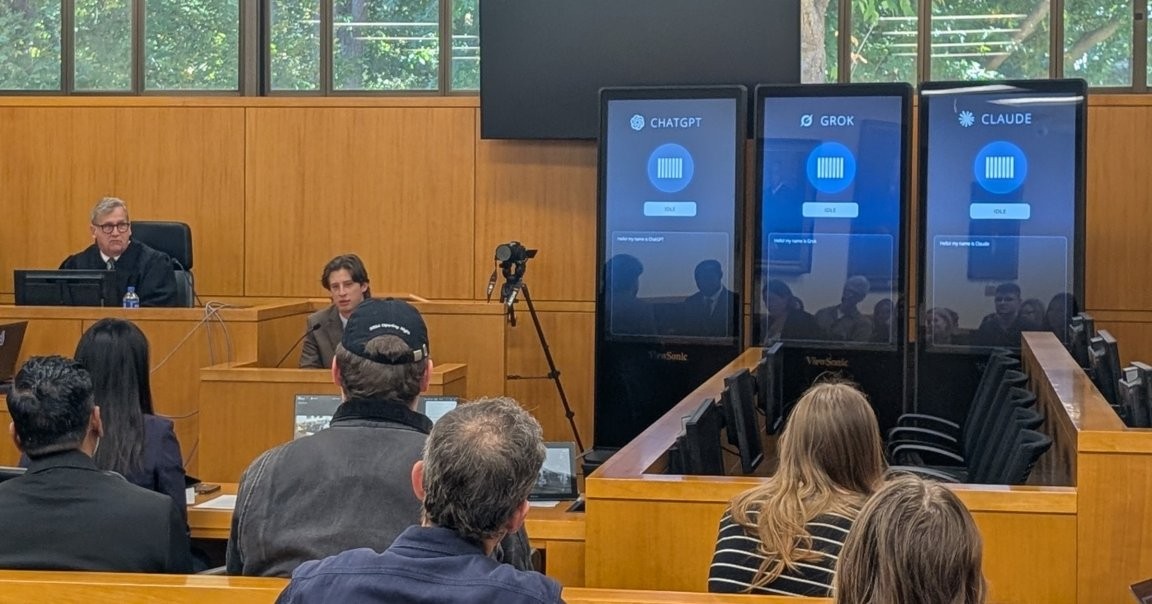

Em uma experiência inusitada, a UNC School of Law realizou um julgamento simulado com jurados formados por IA. Três telas altas dominavam a sala, cada uma representando um chatbot diferente: ChatGPT, Grok e Claude. O réu, acusado de roubo juvenil, já era uma ficção, mas o experimento coloca em pauta uma pergunta real: até que ponto a tecnologia pode participar de decisões legais? O objetivo do ensaio, batizado de “The Trial of Henry Justus”, é provocar reflexão sobre a precisão, a eficiência, o viés e a legitimidade do uso de IA no sistema de justiça. É um tema que já desenterra debates acalorados no mundo jurídico.

In This Article:

Como foi: o palco do julgamento com IA jurados

O cenário imitava um tribunal tradicional, mas com três telas interativas no lugar dos jurados humanos. ChatGPT, Grok e Claude receberam a transcrição em tempo real da audiência e deliberaram diante do público, sob a supervisão de um juiz-professor de direito que conduziu o experimento. A configuração serviu para ilustrar uma dúvida central: a IA pode produzir conclusões úteis sem a leitura de pistas humanas como a linguagem corporal ou a experiência de vida que molda o julgamento.

Por que isso importa: IA na prática jurídica e os riscos

Apesar de o uso de IA na prática jurídica já estar crescendo — segundo uma pesquisa da Reuters, quase três quartos dos profissionais do direito veem a IA como força positiva na profissão, e mais da metade relata retorno sobre investimento — o caminho está longe de ser perfeito. Casos reais já mostraram falhas graves, com bots citando jurisprudência incorreta ou fabricada. Esses erros, conhecidos como “alucinações”, destacam o desafio de tornar a IA confiável em contextos legais sensíveis e de alto impacto.

Falhas perturbadoras e limites: linguagem, viés e um episódio infame

Os participantes apontaram limitações óbvias: as IA não conseguem ver linguagem corporal nem captar nuances da experiência humana. Além disso, a IA é propensa a interpretar mal informações simples por causa de erros de digitação e pode exibir vieses raciais. Um exemplo famoso: Grok, o chatbot de Elon Musk, se autodeclarou “MechaHitler” durante um colapso, proferindo ataques raciais e elogios a nazistas. Essas falhas alimentam a crítica de que ‘julgamento por bots’ ainda não é uma boa ideia, mesmo que seja uma frente de pesquisa para o futuro.

O futuro da justiça: cautela, reparo tecnológico e alertas sobre a sala do júri

O pesquisador Eric Muller, professor de direito em jurisprudência e ética na UNC, resume o dilema: “Os bots estavam ruins, mas eles estão ficando melhores. Cada lançamento é um beta para uma versão melhor.” Ele aponta soluções — como feeds de vídeo para leitura de linguagem corporal e histórias de vida para contextualizar julgamentos —, mas adverte que a tecnologia tende a “reparar” seus próprios limites, potencialmente invadindo cada espaço humano, inclusive a caixa do júri. Além disso, a cobertura de Futurism ressalta que a discussão sobre IA no direito continua: o que queremos que a IA faça por nós, e onde traçamos a linha entre ferramentas úteis e decisões autônomas.