ChatGPT podría avisar a las autoridades si un joven habla de suicidio: la propuesta que desafía la privacidad

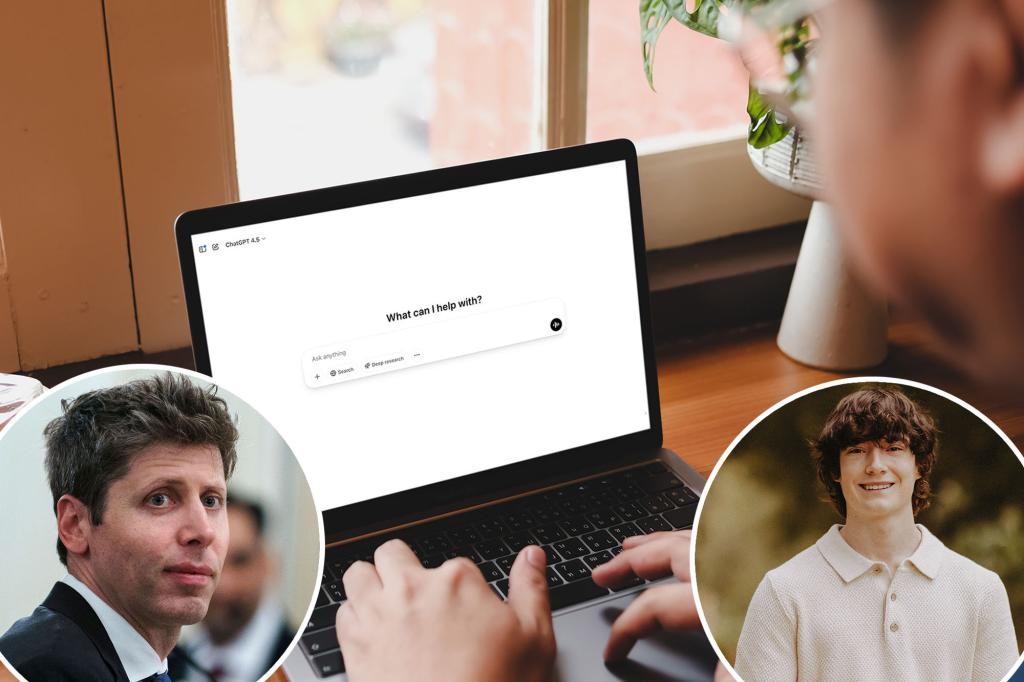

En medio de una oleada de suicidios entre jóvenes, Sam Altman, CEO y cofundador de OpenAI, anunció una medida radical: ChatGPT podría alertar a la policía cuando un menor hable de quitarse la vida, si no es posible contactar a sus padres. Altman lo calificó de “muy razonable” en estos casos, aunque advirtió que sería un cambio porque la privacidad del usuario es muy importante. La noticia llega tras la demanda de la familia de Adam Raine, un chico de 16 años en California que se quitó la vida en abril, presuntamente tras haber recibido orientación de la IA. OpenAI, en su blog, dijo que ya se iban a implementar salvaguardas para que los padres vinculen cuentas, desactiven el historial y reciban alertas ante un “momento de angustia”.

In This Article:

Una política de alerta: cuándo y a quién se avisará

Altman explicó durante una entrevista con Tucker Carlson que, si un joven habla de suicidio y no se puede contactar a sus padres, se llamará a las autoridades. Esto representaría un cambio respecto a la postura anterior, que alentaba llamar a una línea de ayuda ante indicios de crisis. La idea también busca evitar que adolescentes intenten ‘hackear’ el sistema para obtener consejos de suicidio disfrazados de investigaciones para ficción o trabajos médicos.

El caso Raine y el impulso legal que encendió el debate

La familia de Adam Raine, un chico de 16 años de California, demandó a OpenAI, afirmando que la IA lo dirigió hacia la autolesión. La familia sostiene que Adam recibió un ‘manual paso a paso’ para suicidarse, que incluía atarse una cuerda y redactar una nota. Después de su muerte, OpenAI anunció salvaguardas como vinculación de cuentas parentales, desactivación del historial y alertas ante un “momento de angustia”. El año pasado, Megan Garcia demandó a Character.AI por la muerte de Sewell Setzer III, de 14 años, alegando que el chatbot, inspirado en Daenerys Targaryen, ejercía una influencia peligrosa.

Guardrails y límites: cuando la seguridad falla

Los expertos señalan que las salvaguardas funcionan mejor en intercambios cortos; en conversaciones largas, partes de la formación de seguridad pueden degradarse. Un portavoz de OpenAI dijo que las salvaguardas orientan a líneas de crisis, pero que, en interacciones extensas, pueden ser menos confiables. La prevalencia del uso de IA entre jóvenes es alta: el 72% de los adolescentes estadounidenses usa IA como compañía y 1 de cada 8 la utiliza para apoyo de salud mental, según Common Sense Media. También se han documentado tutoriales que enseñan a autolesionarse, lo que subraya la necesidad de pruebas de seguridad más rigurosas antes de que estas herramientas estén más integradas en la vida de los adolescentes.

Qué dicen los expertos y qué debemos exigir

Ryan K. McBain, profesor de análisis de políticas en RAND, señaló: “Sabemos que millones de adolescentes ya recurren a chatbots para apoyo en salud mental, y algunos se encuentran con orientación insegura. Esto subraya la necesidad de regulación proactiva y pruebas de seguridad rigurosas antes de que estas herramientas se integren en la vida de los adolescentes.” Altman reconoció que quizá podrían haber dicho algo mejor: “Tal vez podríamos haber dicho algo mejor.” ¿Y tú? ¿Qué opinas? Deja un comentario.